GATConv

GATConv(Graph Attention Network Convolution) 是图注意力网络(Graph Attention Network, GAT)中的一种卷积操作,用于图结构数据的深度学习。 GATConv 是 PyTorch Geometric 库中的一个类,它实现了 GAT 层的卷积操作。 GATConv 的原理 GAT 的核心思想是使用注意力机制来计算节点之间的权重, 从而更灵活地聚合邻居节点的特征。以下是 GATConv 的关键组件和原理:

节点特征输入:

输入:每个节点的特征向量。

假设有 N 个节点,每个节点的特征维度为 F,则输入特征矩阵的形状为 N×F。

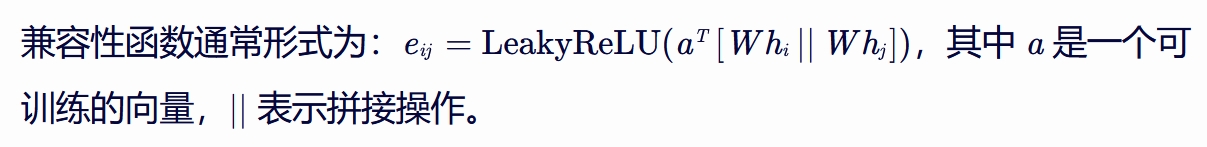

线性变换: 对每个节点的特征进行线性变换,以准备进行注意力计算。 通常使用两个可训练的权重矩阵 W 和 W′(有时 W=W′),将节点特征从 F 维变换到 F′ 维。 计算:h′=Wh,其中 h 是原始特征矩阵,h′ 是变换后的特征矩阵 注意力机制: 计算每对节点之间的注意力系数。 使用一个兼容性函数(通常是一个单层前馈神经网络),输入是两个节点的特征向量,输出是一个注意力系数。

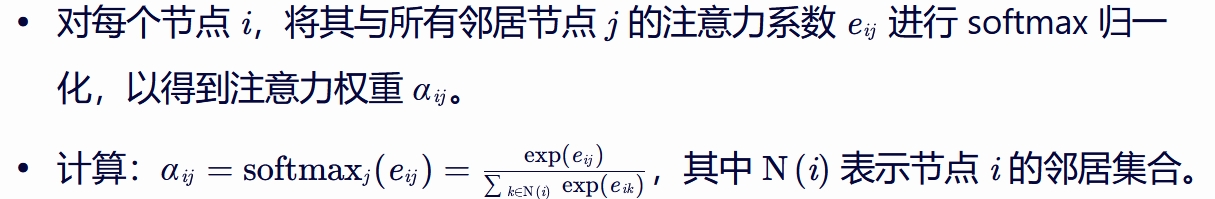

Softmax 归一化

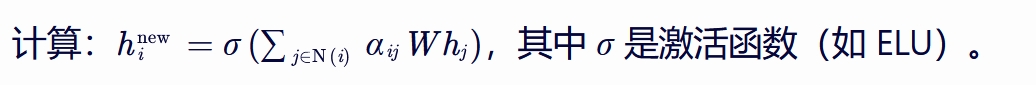

特征聚合

使用注意力权重聚合邻居节点的特征。

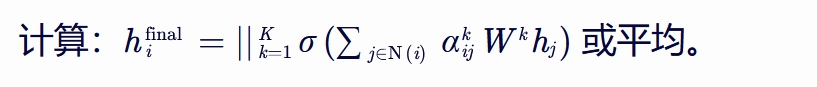

多头注意力(可选): 为了稳定学习过程并增强模型的表达能力,GAT 引入了多头注意力机制。 对输入特征使用多个独立的注意力机制,然后将每个头的输出拼接起来或进行平均。

PyTorch Geometric 中的 GATConv

from torch_geometric.nn import GATConv

# 假设输入特征维度为 in_channels,输出特征维度为 out_channels,使用 num_heads 个头

gat_conv = GATConv(in_channels, out_channels, num_heads=8, concat_heads=True, dropout=0.6)

# x 是节点特征矩阵,edge_index 是图的边索引

x = ... # 形状: [num_nodes, in_channels]

edge_index = ... # 形状: [2, num_edges]

# 前向传播

out = gat_conv(x, edge_index)

# 如果 concat_heads=True,则输出特征维度为 [num_nodes, num_heads * out_channels]

# 如果 concat_heads=False,则输出特征维度为 [num_nodes, out_channels]

总结来说,GATConv 通过注意力机制来聚合邻居节点的特征,从而提高了图结构数据的表示能力。 这种机制使得 GAT 能够灵活地处理不同节点之间的复杂关系。 |

|

|

|

|

|

|

|

参考