强化学习

|

智能体

LLM + 工具集

就是给LLM一组工具集,让LLM根据用户需求选择适当的工具

依据策略执⾏动作-感知状态-得到奖励

强化学习(Reinforcement Learning,RL)是机器学习的一个关键方法,它关注智能体如何与环境互动以最大化累积奖励。

大模型中的强化学习是一种将强化学习(Reinforcement Learning, RL)

与大型语言模型(Large Language Models, LLMs)相结合的技术,

旨在通过强化学习优化大模型的输出,使其更符合人类的偏好或特定任务的需求。

以下是大模型中强化学习的关键概念和应用:

在强化学习中,智能体(Agent)与环境(Environment)进行交互,

根据环境的状态(State)采取行动(Action),并从环境中获得奖励(Reward)。

智能体的目标是最大化累积奖励。

强化学习的基本概念

智能体:训练来做正确决策的实体,旨在通过行动来最大化累积奖励。

环境:智能体与之互动的外部系统。

状态:代表智能体在每个时间点的位置或情况。

动作:智能体在每个时间点在环境中可用的可能选择。

奖励:

由环境根据智能体在每个时间点采取的动作提供的信号或反馈,

通常是一个标量值,用于表示该动作的好坏。

策略:

一组决策规则,帮助智能体在每个时间点选择一个动作。

在实践中,策略通常表示为一种概率分布,指导智能体在不同状态下选择不同动作的概率。

|

|

微调预训练好的模型

在大模型中,强化学习主要用于微调预训练好的模型,

使其与期望的行为保持一致,提高其性能,并确保其输出既有效又可靠。

这通常涉及以下步骤:

收集比较数据: 收集一个包含不同输出之间比较的数据集, 其中标注者指出他们对于给定输入更倾向于哪个输出。 训练奖励模型: 使用收集到的数据集来训练一个奖励模型(RM),以预测人类偏好的输出。 这个奖励模型将用于为不同的大模型输出打分。 策略优化: 利用奖励模型的输出来作为一个标量奖励, 并使用强化学习算法(如近端策略优化PPO)微调模型以优化该奖励。 这个过程会不断迭代,直到模型的表现达到某个阈值或不再显著提高。 强化学习在大模型中的具体方法 在大模型中,强化学习的具体方法可以分为两个主要方向: 传统强化学习方法: 如基于人类反馈的强化学习(RLHF)和基于人工智能反馈的强化学习(RLAIF)。 这些方法需要训练一个奖励模型,并涉及复杂且通常不稳定的过程。 它们使用算法如近端策略优化(PPO)来优化策略模型。 简化方法: 如直接偏好优化(DPO)和相对策略优化(RPO)。 这些方法摒弃了奖励模型,提供了一个稳定、高效且计算效率高的解决方案。 它们直接利用人类偏好数据进行对齐,而无需显式地训练一个奖励模型。 人类偏好训练(Reinforcement Learning from Human Feedback, RLHF) RLHF 是一种将人类反馈整合到强化学习中的方法,主要步骤包括: 监督微调(Supervised Fine-tuning, SFT): 使用标注数据对大模型进行初步微调,使其能够生成初步合理的回答。 奖励模型(Reward Model): 训练一个奖励模型,将生成的内容与人类偏好对应起来,例如给“安全、有用”的回答更高分。 强化学习微调: 使用强化学习方法,让大模型根据奖励模型的评分来更新策略,从而生成更符合人类期望的内容。 作为生成器和决策者 生成器: 在基于模型的强化学习(Model-Based RL)中,大模型可以作为多模态世界模型, 生成高质量的长期轨迹或学习世界状态转移表征。 决策者: 大模型可以直接作为策略网络,根据建模能力和常识知识生成合理的动作。 改进推理能力

通过强化学习,大模型可以学习更复杂的推理过程。

例如,ReSearch 框架通过强化学习训练大模型在多跳问题中进行推理和搜索,而无需使用监督数据。

|

|

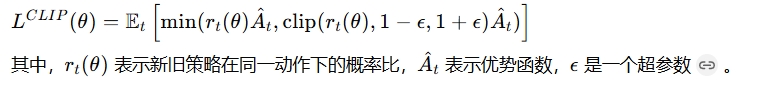

PPO 近端策略优化(Proximal Policy Optimization, PPO) 是一种常用的强化学习算法, 它通过裁剪更新策略来提高训练的稳定性。 PPO 的核心损失函数如下:

|

一般的强化学习流程可以表示为一个马尔可夫决策过程(MDP)。 具体来说,智能体从初始状态开始, 在每个时间步骤,它基于当前状态选择一个动作, 然后进入一个新状态,并获得奖励。 这个过程会不断重复,直到达到某个终止条件(如达到最大时间步骤数或达到某个目标状态)。 智能体的目标是学习一个最优策略,使得在给定状态下选择的动作能够最大化长期累积奖励。 |

|

|

RLHF

大模型中的RLHF(Reinforcement Learning from Human Feedback,简称RLHF)

是一种结合了强化学习和人类反馈的技术,

旨在提高语言模型(如ChatGPT等)的性能和与人类价值观的对齐程度。

具体来说,RLHF通过以下几个步骤实现:

1. 预训练语言模型

首先,在大的数据集上预训练一个初始的语言模型。

这个模型通常是通过自监督方式在一般文本数据集上进行训练的,

使用简单的损失函数(Loss function)来优化模型参数。

然而,这种训练方式生成的内容往往与人类的期望存在差距。

2. 训练奖励模型

接下来,训练一个奖励模型(Reward Model),该模型用于对初始语言模型的行为进行打分。

在强化学习中,给初始模型输入一条指令X,模型生成相应的语句Y,

奖励模型则对这对指令和生成语句(X,Y)进行打分。

这个分数是一个数值,表示人类的偏好程度。

奖励模型的训练数据通常是通过让人类对不同模型生成的文本进行排名或打分来获得的。

3. 使用RL技术进行微调

最后,利用强化学习(Reinforcement Learning,简称RL)技术对初始语言模型进行微调。

在微调过程中,模型会根据奖励模型提供的反馈来优化其参数,以生成更符合人类偏好的语句。

具体来说,模型会尝试生成能够获得更高奖励分数的语句,

从而逐渐学会如何根据人类的反馈来改进其行为。

|

|

RLHF的优势

提高性能:

通过结合强化学习和人类反馈,RLHF可以显著提高语言模型的性能,

使其生成的内容更加准确、流畅和有用。

促进对齐:

RLHF有助于语言模型更好地理解和适应人类的需求和价值观,

从而使其输出更加符合人类的期望和标准。

减少错误决策:

通过人类反馈的引导,RLHF可以减少因环境噪声或数据偏差导致的错误决策,

提高模型的可靠性和稳定性。

|

|

实际应用

RLHF技术已被广泛应用于各种大型语言模型中,如ChatGPT等。

这些模型通过RLHF技术的训练,能够在多个领域提供高质量的文本生成和对话交互服务,

为用户带来更加智能和个性化的体验。

综上所述,大模型中的RLHF是一种结合了强化学习和人类反馈的先进技术,

它对于提高语言模型的性能和与人类价值观的对齐程度具有重要意义。

|

|

|

|

|

SFT

大模型中的SFT(Supervised Fine-Tuning,监督微调) 是一种对已经预训练的模型进行特定任务训练的方法,旨在提高模型在该任务上的表现。 SFT的定义 SFT是指利用有标签的数据集对预训练模型进行进一步训练,以使其更好地适应特定任务的过程。 预训练模型通常在大量无标签或弱标签的数据上进行训练,以学习到广泛的语言知识和特征。 而SFT则是在这些预训练模型的基础上, 通过引入特定任务的有标签数据,对模型进行有针对性的调整和优化。

|

提升模型性能:

通过SFT,模型能够利用预训练阶段学到的通用知识,

并结合新数据的标签信息,在特定任务上表现更好。

这有助于提升模型在文本分类、情感分析、机器翻译等任务上的准确性和效率。

减少标注数据需求: 由于预训练模型已经在大量数据上进行过训练, 因此SFT通常只需要较少的标注数据即可达到良好的效果。 这降低了数据标注的成本和时间。 灵活性: SFT可以应用于各种任务,如文本生成、问答系统、对话系统等。 它使得模型能够根据不同的需求进行定制化训练,从而满足多样化的应用场景。 |

数据准备: 收集并整理特定任务的有标签数据集。 这些数据集应包含足够的样本以覆盖任务的各种情况。 模型加载: 加载预训练模型,并将其作为SFT的起点。 预训练模型应已经具备较好的语言理解和生成能力。 训练设置: 配置训练参数,如学习率、批处理大小、训练轮次等。 这些参数的设置会影响模型的训练效果和训练时间。

训练过程:

使用有标签数据集对预训练模型进行训练。

在训练过程中,模型会根据数据的标签信息调整其参数,以优化在特定任务上的表现。

评估与调整:

训练完成后,使用测试数据集对模型进行评估。

根据评估结果,可以对模型进行进一步的调整和优化。

|

SFT在自然语言处理领域有广泛的应用,如: 文本分类: 使用预训练模型进行情感分析或主题分类等任务。 问答系统: 通过微调模型,使其能够回答特定领域的问题。 对话系统: 通过SFT,使模型能够生成更符合人类对话习惯的回复。 |

优点: 提升模型在特定任务上的性能。 减少标注数据需求。 灵活性高,可应用于多种任务。 缺点: 需要一定的计算资源和时间来进行训练。 数据集的质量和多样性对模型性能有重要影响。 过度训练可能导致模型过拟合。 另外,强化某一方面的能力有可能导致整体的理解推理能力下降, 当然,如果只是应用于特定的任务,这不算是缺点。 |

参考